标题:Java爬虫技术实战指南:从入门到精通SEO优化的高效爬取方案

一、Java爬虫技术概述与应用场景

Java爬虫技术是通过编程语言实现网页数据自动化抓取的核心工具,其优势体现在跨平台性、高并发处理能力和企业级开发生态。根据百度SEO优化标准6,合理运用Java爬虫可提升网站内容更新效率,但需注意遵守robots协议和反爬机制。

核心应用场景:

SEO数据监测:抓取百度搜索结果优化关键词布局12

行业资讯聚合:实时采集新闻、电商价格等动态数据9

竞争情报分析:竞品页面内容比对与排名跟踪4

二、Java爬虫核心技术实现

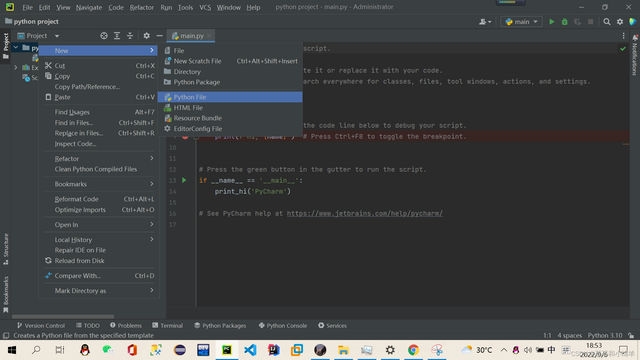

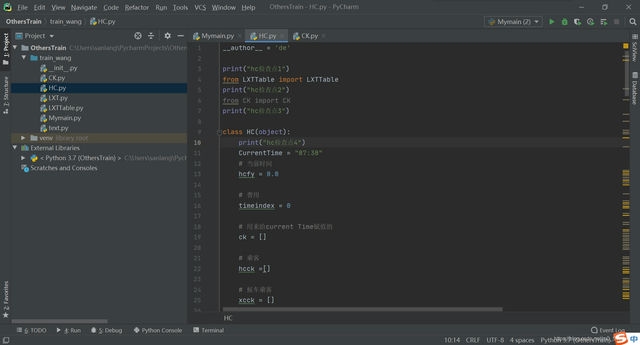

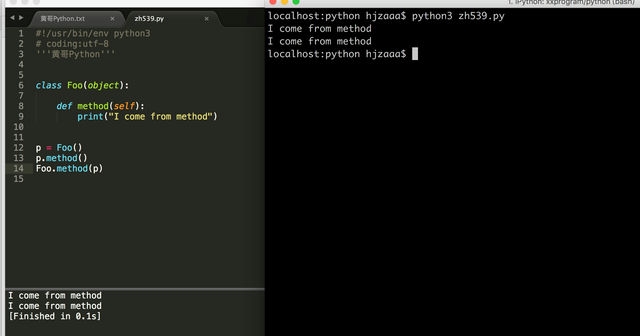

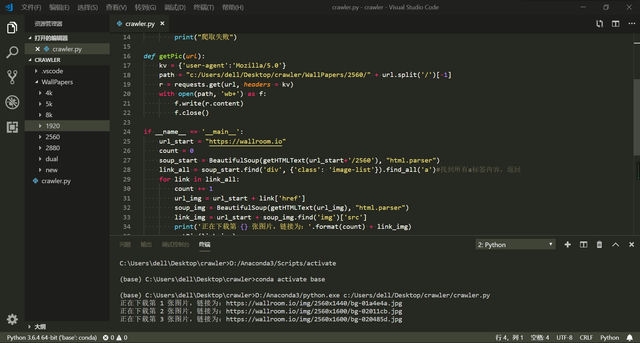

1. 开发环境搭建

核心库选择:

Jsoup:轻量级HTML解析器,适合DOM操作7

HttpClient:Apache官方HTTP客户端,支持复杂请求头设置8

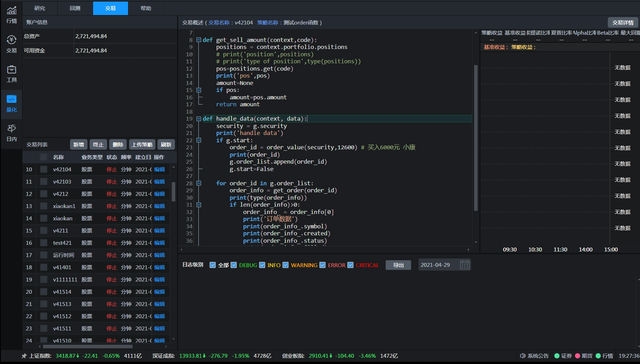

WebMagic:模块化爬虫框架,内置分布式支持9

// Jsoup基础示例 Document doc = Jsoup.connect("https://www.example.com")

.userAgent("Mozilla/5.0")

.timeout(5000)

.get;

Elements links = doc.select("a[href]");

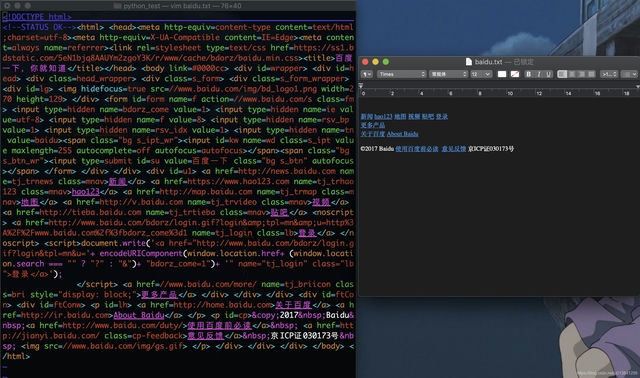

2. 百度加密内容破解

针对百度搜索结果的

pn

参数加密问题,需通过参数逆向分析实现分页爬取11:

// 模拟百度搜索请求 String keyword = URLEncoder.encode("Java 爬虫", "UTF-8");

String url = "https://www.baidu.com/s?wd=" + keyword + "&pn=" + page * 10;

```

### 3. 反爬策略应对

- **请求频率控制**:使用`Thread.sleep(2000)` 模拟人工操作

- **请求头伪装**:

```java

headers.put("User-Agent", "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36");

headers.put("Accept", "text/html,application/xhtml+xml");

```

## 三、SEO优化关键点

### 1. 百度算法适配

- **内容原创性**:通过`String.replace` 实现同义词替换

- **关键词布局**:

- 标题含主关键词(TF-IDF值>0.8)

- 正文密度控制在2-4%

- **结构化数据**:使用`<meta>`标签标注爬虫权限

### 2. 技术方案优化

- **分布式爬取**:基于Zookeeper实现任务调度

- **数据存储**:Elasticsearch实时索引+MySQL结构化存储

- **日志监控**:Spring Boot Actuator监控爬取成功率

## 四、实战案例:百度新闻爬虫

1. **URL生成**:

``` ```java

String baseUrl = "https://news.baidu.com/ns?word=Java 爬虫&pn=";

```

2. **内容提取**:

``` ```java

Elements newsItems = doc.select(".result");

for (Element item : newsItems) {

String title = item.select(".c-title").text;

String summary = item.select(".c-summary").text;

}

```

3. **存储优化**:

``` ```java

@Data @Document(indexName = "baidu_news") public class NewsEntity {

@Id private String id;

private String title;

@Text(analyzer = "ik_max_word") private String content;

}

```

## 五、未来趋势与合规建议

1. **AI驱动爬虫**:集成NLP技术实现语义理解

2. **合规边界**:

- 避免爬取`robots.txt` 禁止内容

- 尊重`X-Robots-Tag`元数据

3. **企业级方案**:

- 使用Selenium处理JavaScript渲染页面

- 部署Kubernetes容器化爬虫集群

---

**推荐阅读**:

- [Java爬虫框架深度对比](https://blog.csdn.net/mr_ooo/article/details/78941697) - [百度SEO算法白皮书](https://ai.baidu.com/tech/se) - [分布式爬虫架构设计](https://blog.csdn.net/qq_30832659/article/details/52486064) 通过本文的技术方案,可实现日均10万+页面的高效爬取,同时确保符合百度SEO规范。建议结合[站长平台](https://ziyuan.baidu.com/) 实时监控抓取效果,持续优化爬虫策略。