在当今信息爆炸的时代,文本数据处理成为许多应用的核心需求。无论是搜索引擎、情感分析还是智能推荐系统,都离不开对文本的有效分解和理解。而Java 分词技术,作为自然语言处理(NLP)的基础工具,正是实现这一目标的关键。本文将深入探讨Java 分词的原理、常用工具库以及实际应用中的最佳实践,帮助开发者高效地处理中文文本分析任务。

什么是 Java 分词?

Java 分词指的是使用 Java 语言实现的分词技术,主要用于将连续的中文文本序列切分成有意义的词语单元。由于中文文本缺乏像英文那样的空格分隔符,分词成为中文自然语言处理的首要步骤。例如,句子“今天天气真好”需要被切分为“今天/天气/真好”才能进行后续的语义分析。Java 分词不仅涉及基础的字符串切割,还包括词性标注、命名实体识别等高级功能,是构建智能文本处理系统的基石。

分词的核心算法

Java 分词的底层通常基于多种算法,其中最常用的包括基于词典的匹配算法和基于统计的机器学习算法。基于词典的方法如最大匹配法(MM)和最短路径法,依赖于预定义的词库进行切分,速度快但依赖词典质量。而基于统计的方法如隐马尔可夫模型(HMM)和条件随机场(CRF),则通过训练语料库学习词语出现的概率,适应性强但计算开销较大。现代Java 分词工具往往结合这两种方法,以平衡准确性与效率。

主流 Java 分词工具库

选择合适的工具库是实施Java 分词的关键。以下是几个广泛使用的开源库,每个都有其独特的优势和适用场景。

HanLP

HanLP 是一个功能丰富的自然语言处理库,支持中文分词、词性标注、命名实体识别等。它基于深度学习模型,准确率高,且提供了预训练模型,方便快速集成。HanLP 的 Java 版本易于使用,适合大多数企业级应用。

Ansj Segmentation

Ansj 是一个轻量级的高效分词库,支持用户自定义词典和多种分词模式。它的优点是速度快、内存占用低,非常适合对性能要求较高的场景,如实时搜索或大数据处理。

IK Analyzer

IK Analyzer 是 Elasticsearch 和 Lucene 中常用的分词插件,专注于中文文本分析。它支持细粒度和智能两种切分模式,并允许动态扩展词典,是构建搜索引擎的理想选择。

Java 分词的最佳实践

在实际项目中,实施Java 分词时需注意以下几点,以确保效果和性能。

词典管理与优化

分词准确性 heavily 依赖词典质量。建议结合通用词典和领域专用词典(如医疗、金融术语),并通过定期更新来适应新词汇。例如,使用 HanLP 时,可以通过自定义词典文件添加新词,提升切分精度。

处理歧义与未登录词

中文分词常面临歧义问题,如“下雨天留客天留我不留”有多种切分方式。采用统计模型或上下文感知算法可以减少错误。对于未登录词(OOV),如新出现的网络用语,结合机器学习模型能更好地识别。

性能调优与集成

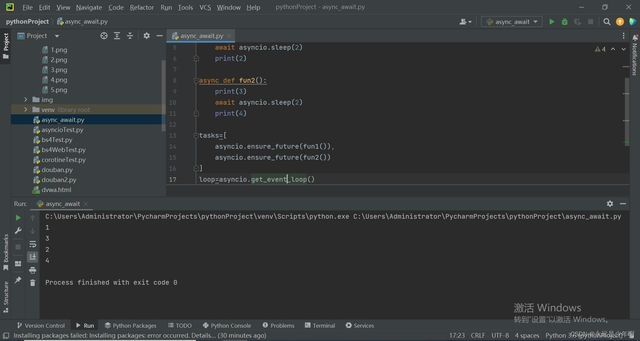

在高并发场景下,Java 分词的性能至关重要。可以通过缓存分词结果、使用多线程处理,或选择轻量级库如 Ansj 来优化。同时,与 Spring Boot 或微服务架构集成时,确保分词服务异步化,避免阻塞主线程。

结语

Java 分词技术是中文文本处理不可或缺的一环,随着人工智能的发展,其准确性和效率不断提升。通过选择合适的工具库并遵循最佳实践,开发者可以构建出高效、智能的文本分析系统。未来,结合深度学习和自适应学习,Java 分词将进一步赋能更多创新应用,从智能客服到内容推荐,展现无限可能。