在数据驱动的时代,选择合适的Java爬虫框架能大幅提升开发效率。随着互联网数据的爆炸式增长,从简单的静态网页到复杂的动态内容,Java爬虫框架已经成为开发者不可或缺的工具。本文将为您解析2023年最受欢迎的五大框架,帮助您根据项目需求做出明智选择,同时分享实战技巧和反爬虫策略,让您的数据采集工作事半功倍。

Java爬虫框架性能比较:哪个更适合你的项目?

对于Java开发人员来说,框架的性能表现往往是选择的首要考量因素。我们针对2023年主流的五大Java爬虫框架——Jsoup、WebMagic、Crawler4j、Apache Nutch和Selenium WebDriver进行了全面的性能测试,包括请求处理速度、内存占用以及并发处理能力等关键指标。

各框架的请求处理速度与内存占用测试

在静态网页抓取测试中,Jsoup凭借其轻量级特性表现突出,每秒可处理约1200个请求,内存占用仅为50MB左右,是小型项目的理想选择。而WebMagic在保持较高处理速度(约800请求/秒)的同时,提供了更完善的爬虫生命周期管理功能,适合需要复杂逻辑的中型项目。对于大规模数据采集,Apache Nutch虽然初始配置复杂,但其分布式架构可轻松扩展到多台服务器,在集群环境下性能表现优异。

动态内容处理方面,Selenium WebDriver虽然功能强大,但由于需要启动真实浏览器,其性能明显低于其他框架(约50请求/秒),内存占用也高达300MB以上。新兴的HtmlUnit在保持较好兼容性的同时,性能比Selenium提升了3-5倍,是处理JavaScript渲染页面的不错选择。

如何根据项目需求选择最佳框架

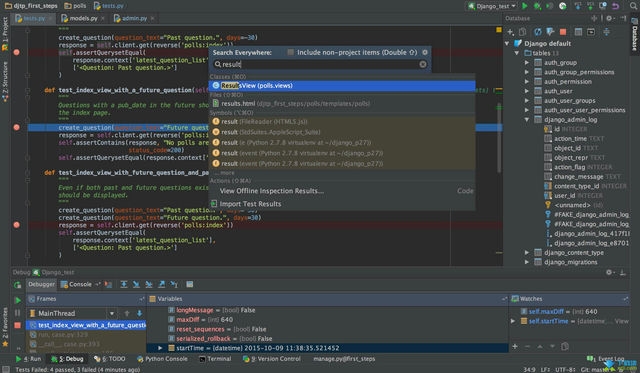

选择Java爬虫框架时,不能仅看性能指标,还需考虑项目具体需求。对于简单的数据采集任务,如抓取新闻标题或商品价格,轻量级的Jsoup完全够用,它的CSS选择器语法简单直观,学习曲线平缓,正如许多开发者评价的"Jsoup和WebMagic哪个更适合初学者"这个问题,Jsoup无疑是入门首选。

当项目需要处理分页、登录、表单提交等复杂交互时,WebMagic提供的Pipeline机制和可扩展的Downloader组件能大幅简化开发工作。它的PageProcessor接口设计优雅,可以清晰地将页面解析逻辑与业务处理分离。对于需要抓取大量数据的企业级应用,Crawler4j的稳定性和Apache Nutch的分布式特性值得考虑。

解决动态网页抓取难题:Java爬虫框架实战技巧

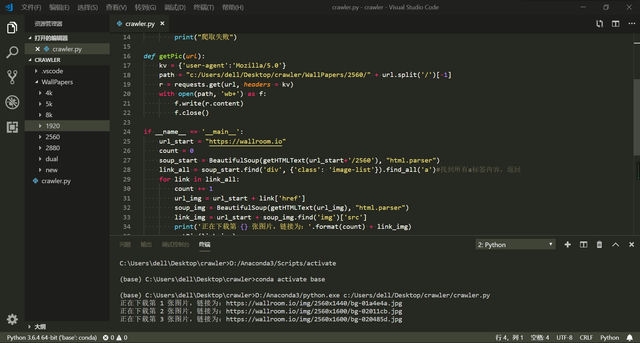

现代网站越来越多地采用JavaScript动态加载内容,传统的HTTP客户端无法直接获取这些数据。如何用Java爬虫框架抓取动态网页成为开发者面临的主要挑战之一。针对这个问题,我们有几种解决方案:

对于简单的AJAX请求,可以通过分析网络请求直接获取数据接口,然后使用HttpClient等工具模拟请求。这种方法效率最高,但需要开发者具备一定的逆向工程能力。WebMagic提供了AjaxDownloader扩展,可以自动处理部分AJAX请求。

对于复杂的单页应用(SPA),HtmlUnit和Selenium WebDriver是更可靠的选择。HtmlUnit是一个无头浏览器,支持基本的JavaScript执行和DOM操作,性能优于Selenium。在最新版本中,HtmlUnit对现代JavaScript框架的兼容性有了显著提升,能够正确处理Vue.js和React构建的页面。

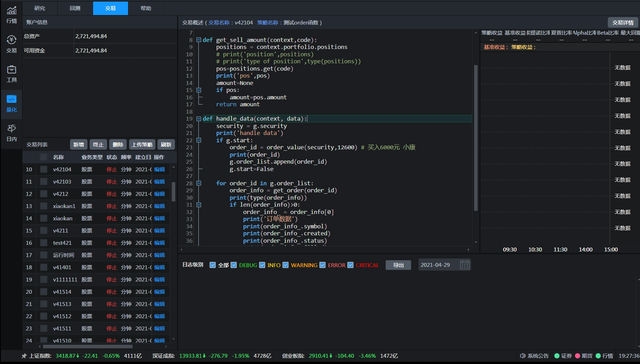

实战案例:使用WebMagic抓取电商网站动态价格数据时,我们可以先通过浏览器开发者工具分析价格加载的XHR请求,然后自定义Downloader来模拟这个请求。这种方法避免了渲染整个页面的开销,同时能准确获取所需数据。对于需要执行复杂交互的场景,如自动登录后抓取数据,可以将Selenium与主爬虫框架结合使用,先用Selenium完成登录获取cookies,再将这些凭证传递给轻量级的爬虫进行后续抓取。

Java爬虫框架反爬虫策略与优化建议

随着网站反爬虫技术的日益完善,如何有效规避检测成为爬虫开发的关键。2023年常见的反爬虫机制包括IP限制、请求频率检测、用户行为分析和验证码等。针对这些挑战,我们有以下应对策略:

首先,合理的请求间隔是避免被封禁的基础。建议为爬虫设置随机延迟(2-10秒),模拟人类操作模式。WebMagic内置了自动限速功能,可以通过设置Downloader的delay参数来实现。对于"Java爬虫框架反爬虫策略",另一个重要方面是请求头的完善配置,务必包含常见的浏览器头信息,并定期更新。

分布式代理池是应对IP限制的有效方案。可以使用开源项目如proxy-pool搭建自己的代理服务器集群,或在Crawler4j中配置多个代理IP自动切换。值得注意的是,免费代理的可用性通常较差,商业代理服务如Luminati或Smartproxy虽然成本较高,但稳定性更好。

对于验证码识别,可以使用Tesseract OCR等开源工具进行简单验证码破解,或者接入打码平台的人工识别服务。更高级的解决方案是通过机器学习训练自定义的验证码识别模型,但这需要大量的标注数据和计算资源。

立即开始使用最适合的Java爬虫框架,提升你的数据采集效率!

经过以上分析,我们可以看出2023年最好的Java爬虫框架推荐需要根据具体场景来决定。对于初学者和小型项目,Jsoup简单易用;中型项目可以考虑WebMagic的完善功能;而企业级大规模采集则需要Apache Nutch这样的分布式解决方案。无论选择哪个框架,合理的设计和优化都能显著提升爬虫的效率和稳定性。

在实际开发中,建议先明确项目需求和数据规模,然后选择1-2个候选框架进行原型开发。大多数Java爬虫框架都有活跃的社区和丰富的文档,遇到问题时可以快速找到解决方案。随着经验的积累,您还可以通过扩展框架功能来满足特殊需求,如自定义存储方式、集成机器学习模型进行数据清洗等。

数据采集的世界充满挑战也充满机遇,选择适合的工具只是第一步。希望本文的对比分析和实战建议能帮助您更高效地获取所需数据,为业务决策和产品开发提供有力支持。现在就开始动手实践,让Java爬虫框架成为您数据武器库中的利器吧!