HDFS作为Hadoop生态的核心组件,掌握其Java API对大数据开发者至关重要。在大数据处理的各个环节中,HDFS提供了高容错性、高吞吐量的数据存储解决方案,而Java作为Hadoop生态系统的原生开发语言,其API的熟练使用直接关系到数据处理效率和应用性能。本文将全面介绍如何在Java中高效操作HDFS,从基础API使用到高级性能优化,帮助开发者解决实际项目中的各种挑战。

HDFS Java API基础使用教程

对于Java开发者而言,HDFS提供了丰富的API接口,使得我们可以像操作本地文件系统一样操作分布式文件系统。要开始使用HDFS Java API,首先需要了解其基本架构和核心类。

HDFS Java客户端环境配置详解

在2023年最新的HDFS Java客户端配置中,我们需要特别注意Hadoop版本的兼容性问题。首先,在Maven项目中添加以下依赖:

<dependency>

<groupId>org.apache.hadoop</groupId>

<artifactId>hadoop-client</artifactId>

<version>3.3.4</version>

</dependency>

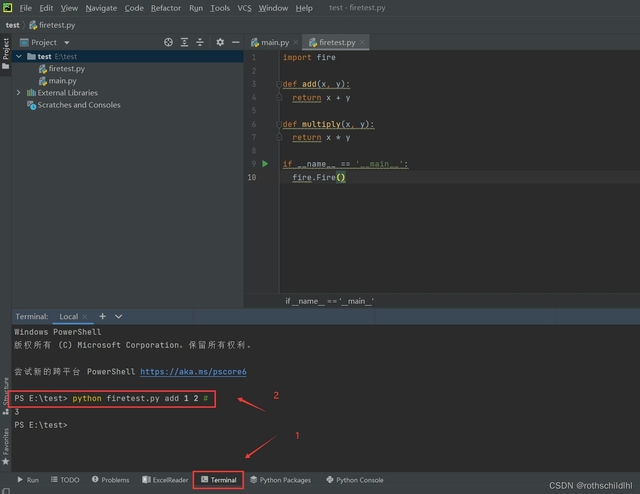

配置HDFS连接时,核心是创建Configuration对象并设置必要的参数:

Configuration conf = new Configuration();

conf.set("fs.defaultFS", "hdfs://namenode:8020");

// 如果需要身份验证

conf.set("hadoop.security.authentication", "kerberos");

UserGroupInformation.setConfiguration(conf);

UserGroupInformation.loginUserFromKeytab("user@REALM", "/path/to/keytab");

如何在Java中连接HDFS的关键点在于正确配置NameNode地址和认证信息。对于开发环境,可以设置conf.set("dfs.client.use.datanode.hostname", "true")来解决某些网络环境下的连接问题。

文件读写操作的核心代码示例

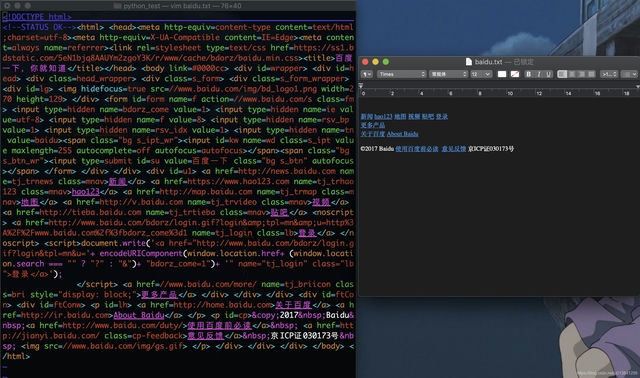

HDFS和本地文件系统在Java中的区别主要体现在API的使用方式和性能特性上。以下是一个完整的文件读写示例:

public class HdfsOperation {

public static void readFile(String hdfsPath) throws IOException {

Configuration conf = new Configuration();

FileSystem fs = FileSystem.get(conf);

try (FSDataInputStream in = fs.open(new Path(hdfsPath))) {

IOUtils.copyBytes(in, System.out, 4096, false);

}

}

public static void writeFile(String localPath, String hdfsPath) throws IOException {

Configuration conf = new Configuration();

FileSystem fs = FileSystem.get(conf);

try (FSDataOutputStream out = fs.create(new Path(hdfsPath), true);

FileInputStream in = new FileInputStream(localPath)) {

IOUtils.copyBytes(in, out, 4096, false);

}

}

}

这个hdfs java api使用教程展示了最基本的文件操作,但实际生产环境中需要考虑更多因素,如异常处理、性能优化等。

解决Java操作HDFS的常见问题与性能瓶颈

在实际开发中,Java读写hdfs文件性能优化是一个持续的过程。以下是开发者常遇到的几个问题及解决方案:

-

连接超时问题:调整

dfs.client.socket-timeout和dfs.client.socket-timeout参数,通常设置为30000(30秒)以上。 -

小文件问题:HDFS不适合存储大量小文件,可以通过以下方式优化:

- 使用HAR文件(归档文件)

- 实现自定义的文件合并策略

-

考虑使用SequenceFile或Avro等容器格式

-

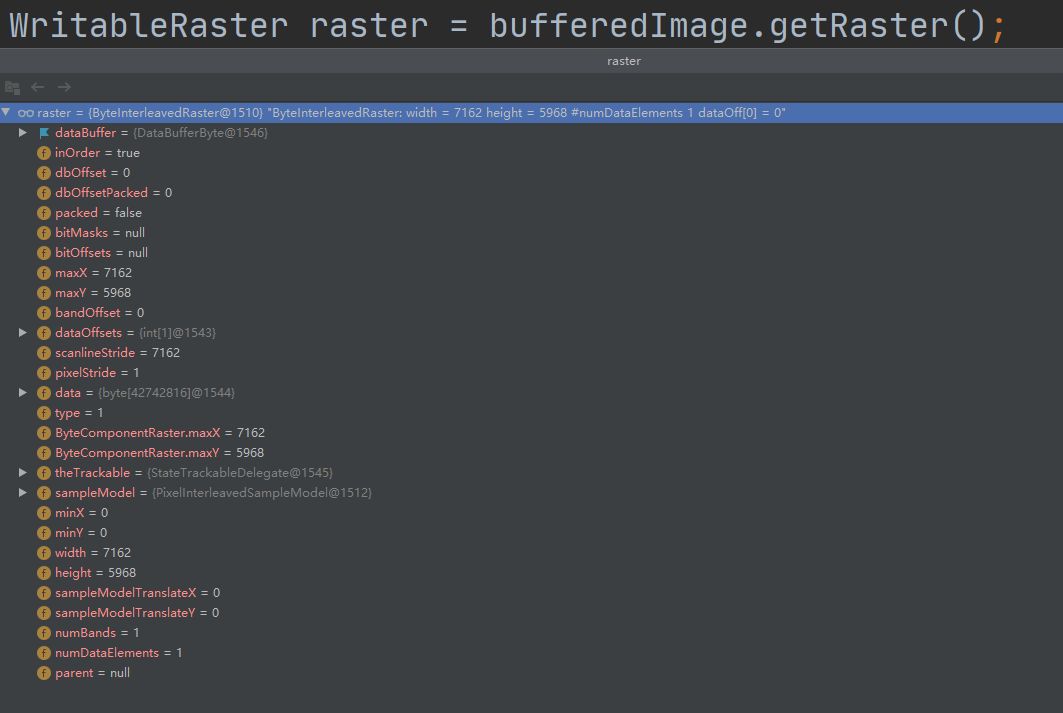

内存溢出问题:处理大文件时,避免一次性读取整个文件到内存,应该使用流式处理:

// 不好的做法:一次性读取

byte[] data = FileUtil.readFileToByteArray(file);

// 推荐做法:流式处理

try (FSDataInputStream in = fs.open(path)) {

byte[] buffer = new byte[4096];

int bytesRead;

while ((bytesRead = in.read(buffer)) > 0) {

// 处理数据

}

}

- 并发写入问题:HDFS不支持多线程并发写入同一文件,需要设计合理的写入策略或使用锁机制。

HDFS Java开发最佳实践与性能优化建议

基于多年的大数据项目经验,我们总结出以下Java操作HDFS的最佳实践:

- 缓冲区的合理设置:根据数据大小和网络条件调整缓冲区大小,通常8KB到64KB之间:

conf.setInt("io.file.buffer.size", 65536); // 64KB缓冲区

- 块大小优化:对于大文件处理,调整HDFS块大小可以显著提高性能:

// 设置256MB的块大小

FSDataOutputStream out = fs.create(path, true, 4096,

(short)3, 256 * 1024 * 1024);

-

使用高效的序列化格式:对于结构化数据,使用Avro或Parquet等列式存储格式比纯文本效率更高。

-

合理利用本地缓存:对于频繁访问的文件,可以使用HDFS的缓存功能:

// 将文件加入HDFS缓存

fs.addCachePool(new CachePoolInfo("myPool"));

fs.addCacheDirective(new CacheDirectiveInfo.Builder()

.setPath(new Path("/frequent/access/file"))

.setPool("myPool")

.build());

- 监控与调优:定期监控以下指标:

- 读写吞吐量

- 操作延迟

- 网络带宽使用情况

- JVM内存和GC情况

现在就开始使用Java高效操作HDFS:总结与进阶学习资源

通过本文,我们系统性地介绍了HDFS Java API的使用方法、常见问题解决方案以及性能优化技巧。作为总结,这里列出几个关键点:

- 始终考虑HDFS的分布式特性,设计适合分布式环境的数据访问模式

- 理解HDFS的"一次写入多次读取"模型对应用设计的影响

- 监控和调优是一个持续的过程,需要根据实际负载不断调整

对于希望进一步学习的开发者,推荐以下资源:

- 官方HDFS Java API文档

- Hadoop权威指南(最新版)

- GitHub上的Hadoop源码和示例项目

- 大数据性能优化相关技术博客和论文

掌握Java操作HDFS的技能是大数据工程师的核心能力之一。随着Hadoop生态系统的持续演进,保持对新技术的学习和实践,将帮助你在数据处理领域保持竞争力。现在就开始应用这些知识到你的项目中,体验高效的大数据处理吧!